GoogleのAI「Gemini 2.0」が、めちゃくちゃパワーアップして登場!今回の進化、マジでヤバいんです。特にすごいのが、「画面共有しながらリアルタイムで会話できる」機能。これ、使ってみたらもう感動モノでした。

目次

Gemini 2.0って何がすごいの?

今までのAIって、テキストで質問したり、ちょっと画像を見せたりするくらいでした。でも、Gemini 2.0は違うんです。

- 声で話せる! → まるで友達と話してるみたいに、自然に会話できる。

- カメラで見てくれる! → カメラに映したものをAIが理解して、教えてくれる。

- 画面も共有できる! → 自分のパソコン画面をAIに見せながら、あれこれ聞ける。

この中でも特に、「画面共有」機能が神がかってるんです。

画面共有機能で何ができるの?

この機能を使うと、こんなことができるようになります。

- 資料を一緒に読む:

- 「この資料、ちょっと難しくて…」って時に、画面を共有してAIに質問。「ここってどういう意味?」って聞くと、AIがリアルタイムで説明してくれる。

- プログラミングを教えてもらう:

- 「このコード、何が間違ってるんだろ?」って時に、AIに画面を見せながら相談。「この部分、もっとこうするといいよ」って、教えてくれる。

- 資料作りを手伝ってもらう:

- 「プレゼン資料、どう作ろうかな?」って時に、画面共有しながらAIに相談。「このグラフ、もっと分かりやすくするには?」って聞くと、アドバイスをくれる。

- パソコン操作を教えてもらう:

- 「あれ?このソフト、どうやって使うんだっけ?」って時に、画面を共有してAIに質問。「ここをクリックして、こうするんだよ」って教えてくれる。

まるでいつも隣に先生や友達がいるみたいで、めっちゃ心強い!

実際に使ってみよう!手順は超簡単

「画面共有」機能、使ってみたい? 実は、やり方はめっちゃ簡単なんです。

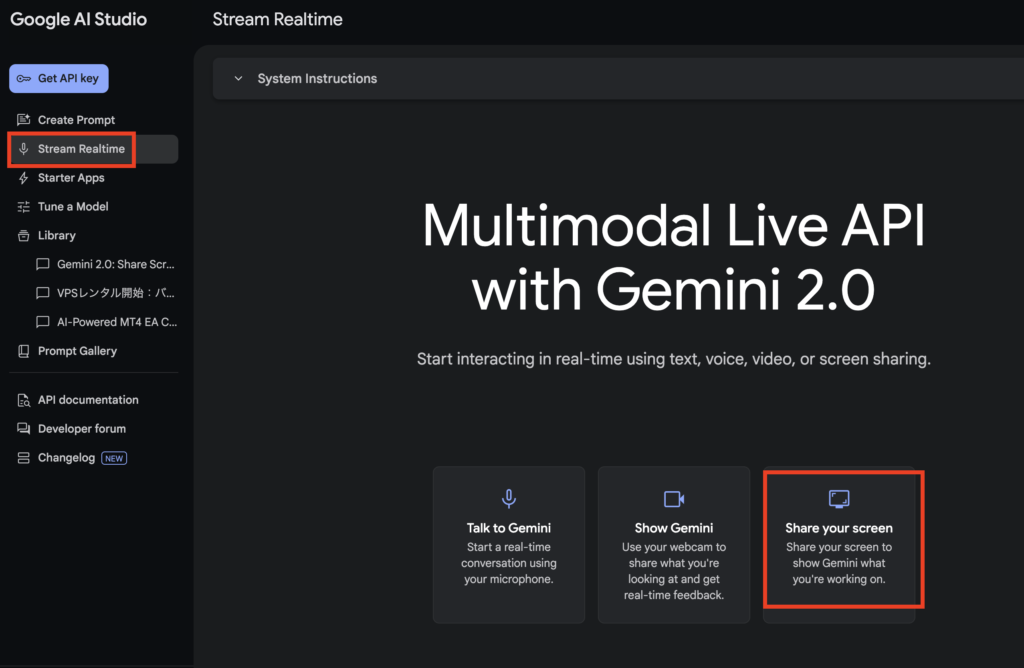

- Google AI Studioにアクセス: まずは、Google AI Studio にアクセス。

- 「Gemini 2.0 Flash」を選ぶ: モデル選択で「Gemini 2.0 Flash (Experimental)」を選んでね。

- 「StreamRealtimeI」を選ぶ: 「StreamRealtime」のところを見て、「Share your screen」を選択。

- 画面共有を許可する: どの画面を共有するか聞かれるので、共有したい画面を選んで許可。

- あとはAIとおしゃべりするだけ! 画面を見せながら、AIに質問したり、相談したりしてみよう。

画像・動画解析、マップ連携:スターターアップスで広がる可能性

Google AI Studioには「スターターアップス」というサンプル実装があり、Gemini 2.0を活用した画像・動画・地図連携のデモを無料で体験できます。

- 画像解析:画像をアップロードすると、物体検出や特定のキーワードに対応するオブジェクトの認識を行います。オレンジ色のキツネやシャドウ、キャットなど、様々なキーワードを入力してオブジェクト検出の精度を確認。「こんなに簡単に複数のオブジェクトを検出できるとは」と感嘆しました。

- 動画解析:動画をアップロードすれば、自動的に字幕生成や時間別要約が可能。自分の動画をアップロードし、即座にトランスクリプトを取得。その字幕精度が非常に高く、日本語のつぶやきレベルの言い直しも正しく反映されていました。「海外動画の理解に使える」「翻訳を組み合わせれば多言語動画視聴が快適になる」といった使い方が想定できます。

- マップエクスプローラー:自然言語で地名や特徴を入力すると、Googleマップと連動して該当場所を表示。「寒い場所」「グリーンな場所」「カフェ in 東京」のような曖昧な指示にも対応。現時点では簡易機能ですが、「文章での地理検索」を洗練すれば、地図検索の新しい形が見えてくると期待されています。

注意点

- まだプレビュー版だから、ちょっと不安定な時もあるかも。

- 今のところ、英語で話すのが一番得意みたい。(でも、日本語でも結構イケる!)

まとめ:これはもう、使わないと損!

今回のGemini 2.0リリースは、

- 精度と速度の劇的向上(フラッシュモデルでプロを超える)

- マルチモーダル(音声・画像・動画・画面共有)対応

- 無料利用枠の太っ腹さと低コスト運用の可能性

- AIエージェントを見据えた豊富なデモ(アストラ、マリーナ、ジェリス、ゲーム用エージェント)

日本語対応はまだ改善の余地がありますが、英語圏でのスムーズな対話や、コード・論文解説を即時で行う様子は十分に実用的です。

オープンAIが12日間連続アップデートする中、Googleは1日で全部出した印象です。